Le monde de l’eau n’échappe pas à la tendance générale : l’intelligence artificielle y est de plus en plus présente… mais ce n’est pas celle qui fait la Une de l’actualité. Il s’agit ici d’un outil numérique au service de l’amélioration des performances des réseaux et usine.

L’intelligence artificielle (IA) est aujourd’hui un sujet de conversation omniprésent, teinté d’espoir ou de crainte. Le monde de l’eau n’est pas épargné, et de nombreuses solutions numériques «métier» s’en réclament. Au-delà de l’effet de mode, que peut apporter l’IA, ou plus largement les technologies numériques avancées, à la gestion des infrastructures d’eau potable ou d’assainissement ?

IA, QUELLE IA ?

L’intelligence artificielle dont tout le monde parle aujourd’hui, utilisée pour créer des textes ou des images, est dite «générative» par les spécialistes. Soyons clairs : le monde de l’eau n’a - pour l’instant ? - que faire d’une IA générative. Les fournisseurs de solutions numériques utilisent cependant plusieurs types d’algorithmes ou procédés avancés, que l’on pourrait inclure dans l’intelligence artificielle, d’autant que la définition de cette dernière semble assez floue.

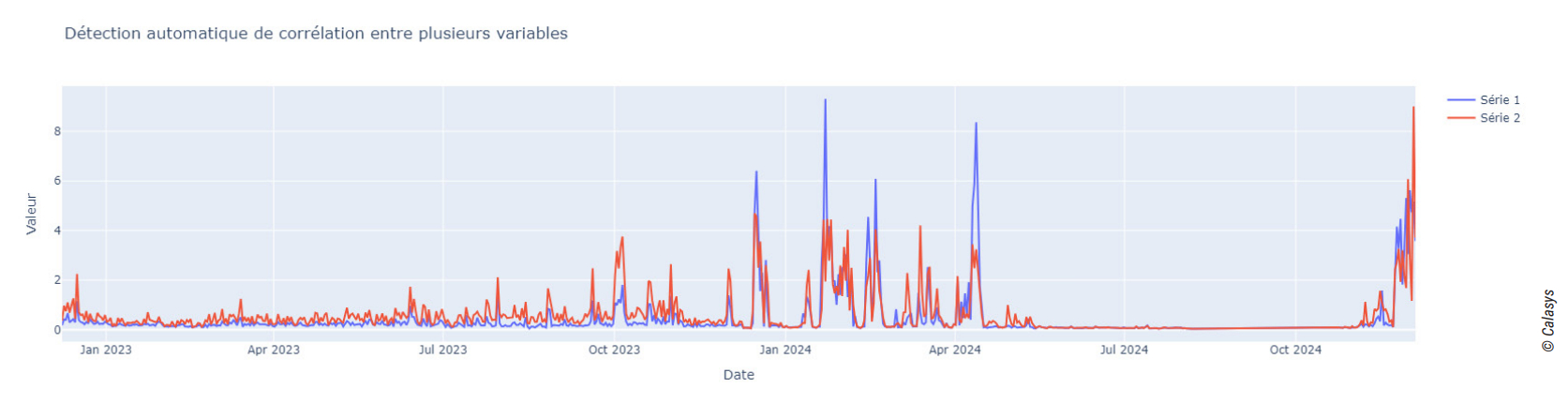

«C’est un mot «fourre-tout». On pourrait évoquer des programmes informatiques reproduisant des processus cognitifs humains, mais cela reste vague. A Calasys, nous n’utilisons pas d’IA générative mais entraînons des modèles statistiques pour prédire des évènements à partir de données de terrain. Il s’agit essentiellement d’apprentissage machine ou Machine learning» explique Antoine Loechner, data scientist – ce qu’il traduit par «ingénieur en IA» - chez Calasys.

Pauline Lorin, Marketing Manager BU Water chez Purecontrol, la voit plutôt comme «un ensemble de technologies informatiques capables de faire des « raisonnements » ou de chercher des objectifs de façon autonome». Tenant elle aussi à éviter la confusion avec l’IA générative, elle précise que Purecontrol fait essentiellement de l’optimisation.

«On questionne souvent, à juste titre, le bilan environnemental de l’IA. En ce qui nous concerne, nous estimons que la consommation énergétique de nos serveurs représente moins de 1% des économies d’énergie que nous faisons réaliser à nos clients» tientelle à préciser.

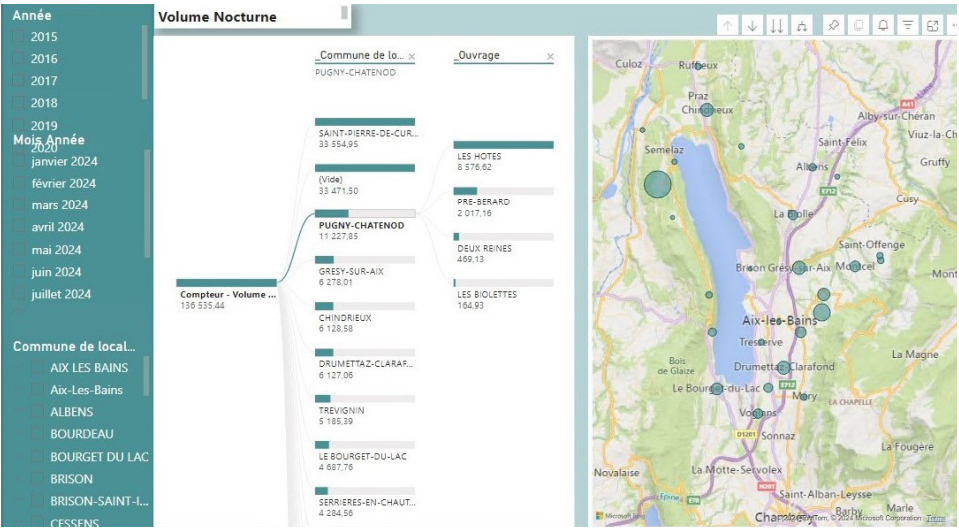

Cette logique d’optimisation ciblée trouve aussi un écho chez d’autres fournisseurs. Itron, par exemple, a développé une fonctionnalité baptisée Night Flow, intégrée dans ses compteurs intelligents (Intelis wSource et Cyble 5), permettant une gestion plus réactive des réseaux d’eau pendant les heures creuses. En remontant les données de comptage toutes les 15 minutes au lieu d’une fois par heure, la solution permet de détecter plus finement des fuites ou variations de pression susceptibles de passer inaperçues en journée. Ces données sont ensuite centralisées et analysées dans la plateforme Temetra, qui permet d’écarter les fausses alertes. «L’intégration de l’IA transforme chaque donnée en décision stratégique, permettant d’anticiper les problèmes avant leur apparition», souligne Charles-Alexandre Concedieu, Sales Manager Eau France chez Itron.

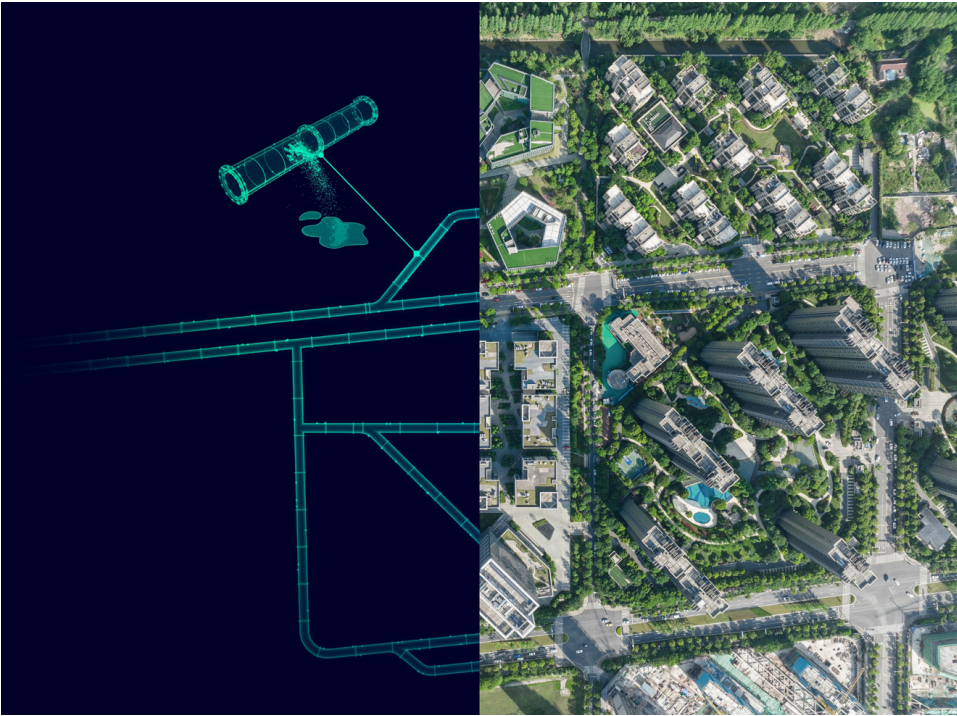

Une autre approche de la détection des fuites s’appuie sur l’analyse croisée des données en temps réel et des modèles hydrauliques. Siemens propose ainsi l’application cloud SIWA Leak Finder, qui utilise l’intelligence artificielle pour détecter et localiser plus rapidement les pertes sur les réseaux d’eau potable. «Nous analysons les données de débit en continu, en les croisant avec des modèles hydrauliques, afin d’identifier les fuites et de localiser leur origine avec une précision accrue», explique Christophe Bonnefoi, en charge du développement des solutions pour le cycle de l’eau chez Siemens France. L’application exploite les débitmètres existants – notamment les modèles SITRANS Mag8000-4G – et s’appuie sur un algorithme de positionnement optimisé des capteurs, capable de recommander leur emplacement idéal selon la configuration du réseau.

Deux niveaux de service sont disponibles, dont une version avancée capable de créer des zones de comptage virtuelles pour les réseaux non sectorisés ou très étendus. L’application peut aussi être associée à des modules de gestion patrimoniale, pour hiérarchiser les investissements de renouvellement en fonction de l’état des canalisations, ou à un jumeau numérique, permettant de simuler différents scénarios d’exploitation et d’en anticiper les effets. Dans les réseaux d’assainissement comme d’eau potable, l’IA peut restructurer l’information issue du terrain, anticiper les dérives de fonctionnement et produire des analyses exploitables pour le pilotage en continu.

Le Groupe ALCOM met en avant une approche sur mesure, fondée sur l’analyse collaborative et l’adaptation aux contraintes opérationnelles. «Chaque situation est unique. Plutôt que des solutions toutes faites, nous construisons, avec nos clients, des déploiements conçus pour créer de la valeur rapidement», souligne Marie Iaquinta. «Nous travaillons beaucoup sur le pilotage d’installations en temps réel. L’IA est un des outils logiques mais pas le but en soi. Nous utilisons en fait toute une palette de méthodes numériques : IA, apprentissage machine, régulation PID (proportionnelle, intégrale, dérivée) classique, logique floue, etc.» explique pour sa part Lynne Bouchy, Product Line manager chez Createch 360.

Pour Sébastien Papin, Directeur BU Environnement chez Qualisteo, c’est clair : «la conscience artificielle n’existe pas. On utilise «simplement» des algorithmes allant au-delà des programmes automatiques classiques pour analyser simultanément une énorme quantité de donnés, sous différentes dimensions, afin de prédire (parfois), anticiper ou, au mieux, paramétrer en temps réel le fonctionnement des usines ou réseaux.» Victor Philippon, responsable des solutions numériques pour les réseaux d’eau et d’assainissement chez Xylem, insiste lui aussi sur le flou entourant la définition même de l’IA, et son utilisation dans le monde de l’eau.

«Notre plateforme Xylem Vue utilise effectivement l’IA mais il existe beaucoup de types d’IA, et les frontières sont mal définies. L’IA reste un moyen de faire ce qu’on ne pouvait pas faire avec les outils précédents. Il existait déjà, par exemple, des algorithmes génétiques. Avec l’augmentation des capacités de calcul et la montée des compétences chez les informaticiens, on fait de plus en plus appel à l’IA pour certains usages, mais cela reste un outil parmi d'autres» détaille-t‑il.

LES DONNÉES : UNE MATIÈRE PREMIÈRE À RAFFINER

IA ou pas, les solutions numériques avancées utilisées dans le monde de l’eau (comme ailleurs) exploitent une matière première: les données de terrain remontant des installations, et parfois également de sources externes (météo par exemple). Aujourd’hui, il n’existe guère d’infrastructure de potabilisation, distribution d’eau potable, collecte d’eaux usées ou épuration qui ne soit pas équipée de capteurs, d’automates voire de supervision.

Autrement dit: les données brutes ne manquent pas dans le monde de l’eau. Encore faut-il pouvoir les récupérer et les rendre utilisables pour des algorithmes «avancés». C’est souvent la première étape de traitement des solutions numériques «métier». Et dès ce stade, l’IA peut désormais se révéler utile, bien qu’il existe déjà des méthodes numériques éprouvées. «Les méthodes traditionnelles de détection des fuites, telle la détection acoustique, sont efficaces mais elles reposent sur l’expertise humaine et l’analyse de données de base. En intégrant l’IA et le traitement avancé des données dans ces technologies, comme cela est la cas dans nos solutions ON’connect™ et AQUADVANCED®, nous améliorons l’efficacité de la détection des fuites et permettons aux opérateurs une détection plus précoce et précise des fuites sur les réseaux d’eau.» ajoute Claire Mathieu.

En effet, avec la digitalisation et l’automatisation croissantes des installations dans le domaine de l’eau, de nombreuses données sont désormais remontées: non seulement sur les équipements de production, mais aussi sur les quantités traitées, la qualité, l’usure des composants ou d’autres indicateurs clés de performance. «Les compteurs d’eau intelligents permettent aujourd’hui de suivre les consommations en temps réel et de mieux les piloter», ajoute Claire Mathieu. «En croisant ces données avec celles sur la disponibilité de la ressource, les collectivités peuvent ajuster les approvisionnements et anticiper les situations de stress hydrique. Avec notre solution ON’connect™, cette approche a permis d’atteindre jusqu’à 16 % d’économies d’eau, notamment grâce à une détection plus fine des fuites et une meilleure compréhension des usages.»

«C’est dans ce contexte que nous proposons, chez Phoenix Contact, une approche ouverte avec notre gamme d’automates de technologie PLCnext», explique Willy Mulot, chef de produit automation. «Notre automate AXC F 3152 peut être complété par le module AXC F XT ML 1000, dédié au traitement d’applications d’intelligence artificielle en périphérie. Il permet, par exemple, de détecter des éléments défectueux ou conformes, de comparer des produits ou images, ou encore de réaliser du comptage, le tout dans un environnement programmable et interopérable.» Ce constat est partagé bien au-delà du secteur de l’eau.

Pour Dr Johannes Kühn, responsable de l’ingénierie de contrôle chez Lenze, «tout commence par les données – mais pas n’importe lesquelles. Il faut privilégier les données intelligentes à la masse brute.» Selon lui, l’intelligence artificielle reste aujourd’hui peu présente dans le cœur des machines industrielles, où la fiabilité prévaut sur l’expérimentation. «En revanche, autour des processus de production, dans la maintenance conditionnelle, la gestion des pièces ou l’analyse prédictive, l’IA progresse rapidement», poursuit-il. Lenze met ainsi à profit l’expérience de ses équipes pour déterminer quels signaux capter sur ses moteurs, afin d’en tirer des indicateurs d’usure sans surcharge de calcul inutile. «Une IA bien entraînée ne remplace pas l’expertise, elle la complète. C’est l’ingénieur qui sait quels signaux sont réellement pertinents pour surveiller un couple ou anticiper une panne.»

L’entreprise propose une interface logicielle, Drives Datahub, pour rendre ces données accessibles via différents protocoles de communication, et permettre leur exploitation dans des tableaux de bord ou via des plateformes comme Nupano. Une manière d’illustrer que la valeur de l’IA dépend aussi de la qualité de l’infrastructure en amont.

Cette logique d’intelligence embarquée progresse également du côté des équipements eux-mêmes. Le nouveau variateur décentralisé i650 motec, par exemple, intègre des fonctions de positionnement adaptées à des applications comme les convoyeurs ou stations de levage. Cette exploitation de la donnée ne se limite pas aux équipements de production.

L’intelligence artificielle peut également optimiser les opérations sur le terrain, en exploitant des données géographiques et logistiques. Itron, par exemple, intègre dans sa plateforme Temetra une fonctionnalité baptisée Georouting, qui permet d’optimiser dynamiquement les tournées de relève des compteurs, les interventions de maintenance ou les dépannages.

«Grâce à Georouting, nous pouvons non seulement optimiser les parcours de nos équipes, mais aussi prédire les besoins d’interventions futures en analysant les tendances de consommation et les événements météorologiques», explique Charles-Alexandre Concedieu.

«La première étape de notre intervention consiste à numériser puis «digérer» les données pour qu’elles soient utilisables. Les capteurs produisent en effet des quantités importantes de données, qui ne sont pas toujours traitées et valorisées» souligne Lynne Bouchy (Createch). «Nous avons développé des connecteurs permettant de récupérer des données brutes, internes ou externes, provenant d’API1 , de bases de données, d’automates, etc. Puis nous organisons et structurons les données par des moyens classiques, qui nécessitent un certain paramétrage», explique Priscille Janodet, responsable du produit Diagbox chez Calasys. «L’intelligence artificielle, quant à elle, est mobilisée pour qualifier ces données : repérer les valeurs manquantes ou incohérentes, détecter des événements marquants sur le réseau, et proposer, à terme, des opérations de correction ou de reconstitution automatique.» Ce besoin de qualification en amont est partagé par d'autres acteurs.

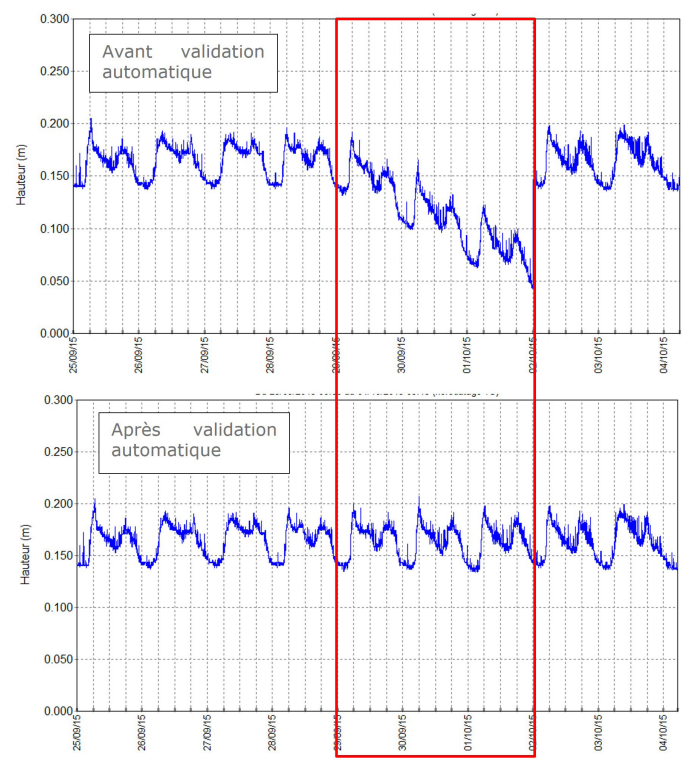

Prolog Ingénierie, qui développe des solutions logicielles pour l’eau depuis les années 1980, insiste également sur la nécessité de valider les données de terrain avant leur traitement par des modèles d’IA. «Dans les réseaux d’assainissement, les capteurs sont exposés à des conditions extrêmes : humidité, gaz comme le H2 S, obstacles, ou encore accès difficile pour la maintenance. Cela engendre un risque important de données erronées», explique Christophe Soriano, chef de projet chez Prolog Ingénierie. Pour répondre à cette contrainte, l’entreprise a intégré un module de validation automatique dans son logiciel EVE’m, utilisé par plus de 200 collectivités. Ce module s’appuie sur un algorithme de deep learning, conçu pour traiter des séries temporelles, notamment pour contrôler la position des vannes ou le fonctionnement des pompes. Cette validation peut être utilisée en temps différé (pour l’autosurveillance, le diagnostic, etc.) ou en temps réel, afin de garantir que les modèles de prévision reposent sur des données fiables.

Le groupe Alcom partage cette priorité accordée à la fiabilité des données. Pour faciliter le travail des exploitants, ses équipes ont développé des outils d’IA dédiés à la validation automatique, capables de détecter les incohérences, les dérives de capteurs ou de reconstruire des données manquantes. «La donnée liée à l’eau est incertaine par nature. Nous avons conçu des IA pour soulager les experts de cette tâche répétitive, réduire les risques d’erreurs et répondre aux exigences réglementaires de traçabilité», explique Marie Iaquinta, directrice générale adjointe du Groupe Alcom. Leur plateforme DataValid permet ainsi de traiter de manière autonome des chroniques mensuelles de données, en particulier dans les réseaux soumis à des normes de rejet de plus en plus strictes.

Pour la plateforme Xylem Vue également, la mise à niveau des données brutes est une première étape indispensable. «Nous utilisons l’IA dès cette «couche basse», pour prendre en compte et compenser des données fausse ou manquantes par exemple» explique Victor Philippon.

«Nous pouvons même créer des donnés virtuelles. Par exemple, sur les plus de 500 STEU que nous contrôlons, 95 % sont dépourvues de sonde ammonium, ou alors ses données sont peu fiables. Cela ne nous empêche pas d’optimiser le cycle d’aération en fonction d’une valeur d’ammonium… que nous créons sur la base d’autres données.

De la même manière, si par exemple un château d’eau est seulement équipé d’une sonde de niveau et d’un débitmètre d’entrée, nous pouvons créer un débitmètre de sortie virtuel et exploiter ses informations» ajoute Pauline Lorin, de Purecontrol.

Cette transformation des données ne peut toutefois avoir lieu que si ces dernières sont correctement collectées et transmises, ce qui constitue un défi en soi. Comme le souligne Alain Cruzalèbes, responsable technico-commercial chez Perax: «L’intelligence artificielle devient aujourd’hui indispensable pour qualifier, analyser et corréler des données de terrain toujours plus nombreuses et précises. Mais face à la multiplicité des sources – capteurs, automates, plateformes IoT, superviseurs ou hyperviseurs – la collecte initiale reste un véritable défi technique.» Pour y répondre, certains fabricants intègrent désormais, dès la conception de leurs équipements, des protocoles de communication standardisés comme le MQTT. L’objectif est de permettre une alimentation directe des outils d’intelligence artificielle, sans passer systématiquement par des plateformes propriétaires ou intermédiaires, et ainsi se concentrer sur l’analyse des données plutôt que sur leur accès.

Cette logique de connectivité directe et interopérable est également portée par Netmore France, qui collabore avec de nombreux acteurs du secteur de l’eau et des éditeurs de plateformes logicielles. En assurant la transmission des données de terrain (comptage, sous-comptage, détection de fuites) via des protocoles standards (API, MQTT, Cloud), l’entreprise contribue à garantir la continuité et la fiabilité des flux de données vers les moteurs d’analyse et d’intelligence artificielle. Cela permet aux systèmes connectés d’accélérer les prises de décision, en particulier pour la détection et la localisation des anomalies sur les réseaux.

Rendre les données accessibles ne suffit pas : encore faut-il pouvoir les interpréter dans leur contexte. «Les données doivent être correctement structurées et géoréférencées. C’est là que les systèmes d'information géographique (SIG) jouent un rôle déterminant», souligne l’équipe d’Esri France. En croisant capteurs de terrain, modèles hydrauliques et cartographie dynamique, les SIG permettent de centraliser, visualiser et enrichir les données pour en tirer une information exploitable par l’IA. Ces outils facilitent la compréhension des réseaux, la détection d’anomalies et la gestion opérationnelle en temps réel. Combinés à l’intelligence artificielle, ils deviennent ainsi des leviers puissants d’anticipation, de pilotage et de résilience, à l’échelle de tout un territoire. Cette mise en contexte des données, qu’elle soit spatiale ou opérationnelle, ne doit pas faire oublier une exigence fondamentale: la cohérence entre les systèmes qui produisent et consomment ces données.

Guillaume Gimenez, fondateur de 2Gi Technologie, met en garde contre la tentation de multiplier les outils d’acquisition sans harmonisation: «L’acquisition des données n’affranchit pas de leur typage ni de leur normalisation au bénéfice de tous les systèmes qui les exploitent. À défaut, chaque outil définit son propre référentiel, avec sa propre définition des indicateurs, ce qui entraîne des divergences et des surcoûts.» Pour lui, l’intelligence artificielle ne doit pas être perçue comme une surcouche autonome mais comme une brique complémentaire, au service de la structuration, de la qualité et de l’enrichissement des données : «Les notions de référentiel et de qualité des données ne sont pas propres à l’IA. Ce sont des bases de tout système robuste. L’erreur classique est de construire un château de cartes en empilant les technologies sans les intégrer réellement à l’écosystème existant.»

La société Tenevia, filiale du Groupe Alcom, développe des systèmes d’analyse d’images embarqués dans des caméras pour mesurer en continu hauteur et débit des cours d’eau. Cette IA embarquée basse consommation permet de déclencher des alertes uniquement en cas de franchissement de seuils critiques, réduisant le volume de données à transmettre tout en garantissant une réaction rapide en cas d’événement hydrologique majeur.

DES OBJECTIFS « MÉTIER » DIVERS

Pourquoi utiliser ces techniques numériques avancées alors que la plupart des usines et/ou réseaux sont déjà instrumentés, automatisés et supervisés ? Tous les fournisseurs de solutions «métier» avancent les mêmes objectifs: modéliser les installations pour prédire leur comportement en fonction de données internes ou externes, optimiser les processus en temps réel, aider à la décision à moyen-long terme (maintenance, gestion patrimoniale). De manière générale, il s’agit donc d’aller au-delà des exigences de base – distribuer une eau conforme, respecter les normes de rejet dans le milieu – pour améliorer la performance des installations ou des services.

«La modélisation des installations et la prédiction de leur comportement peuvent avoir un intérêt à court ou moyen terme. A court terme, il s’agit d’optimisation, à moyen terme de résilience ou de développement des infrastructures. Cela ne nécessite évidemment pas les mêmes outils numériques. Createch travaille sur le court terme, l’optimisation des procédés en «temps réel» visant des gains d’énergie, de réactifs, de rendement… C’est là que se font les gains tangibles. De plus, les outils data analytics de notre plateforme permettent à chaque utilisateur de valoriser ces données en élaborant ses propres KPIs et hypervision, en support de décisions opérationnelles stratégiques moyen terme» explique ainsi Lynne Bouchy pour Createch.

La société Aquassay propose une solution numérique baptisée e-Water Efficiency, aujourd’hui déployée dans de nombreux sites industriels et quelques installations urbaines. Elle permet d’agréger et de structurer des données issues de capteurs, d’automates, d’analyses ou d’indicateurs de statut machine, afin de produire une représentation systémique des usages de l’eau et d’identifier des leviers d’amélioration. Dans les cas les plus avancés, des modules intégrant des briques d’intelligence artificielle sont mis en œuvre pour prédire certaines dérives (par exemple de qualité en sortie de station ou de consommation énergétique) et simuler différents scénarios de pilotage.

L’outil vise à fournir une aide à la décision en intégrant des critères liés à la performance économique et opérationnelle (eau, énergie, sécurité, temps opérateurs, etc.). «La Diagbox crée des indicateurs «métier» de performance et de santé des réseaux, comme par exemple les volumes d’eaux claires parasites ou d’eaux météoriques entrant dans un réseau d’assainissement, les volumes de pertes d’eau potable par secteur d’un réseau de distribution, la consommation énergétique, etc. Ces indicateurs, calculés toutes les heures et faisant l’objet d’un rapport quotidien, aident à la décision opérationnelle. Nous proposons également un module réglementaire. Il s’agit là de traiter les données d’analyse et d’autosurveillance et générer automatiquement des rapports Sandre réglementaires» avance pour sa part Priscille Janodet, pour Calasys.

La Diagbox équipe déjà des collectivités comme Angers, Chambéry, Valence ou Villefranche-sur-Saône, entre autres. Calasys poursuit son développement en travaillant à de nouveaux modules. «Dans un futur proche, nous pourrons optimiser la consommation énergétique des pompes de distribution sur tout un réseau. Nous travaillons aussi à un module d’aide au choix des ressources, pour les collectivités qui disposent de plusieurs captages ou ressources de surface» précise ainsi Antoine Loechner. Dans les régions soumises à des tensions croissantes sur la ressource, l’intelligence artificielle peut aider à anticiper la disponibilité de l’eau et à adapter les stratégies de distribution.

«Pour anticiper les périodes de stress hydrique, il est crucial de prédire si les ressources disponibles dans les réseaux seront suffisantes. En croisant les données de consommation issues des compteurs intelligents avec celles sur la disponibilité de la ressource, l’IA permet aux collectivités d’ajuster les approvisionnements et de détecter les usages anormaux ou les fuites», explique Claire Mathieu, Head of Data & IA chez Suez Digital Solutions. «Nous travaillons sur un module d’anticipation de la demande en eau potable. Pour cela, nous allons bientôt lancer un système de qualification des données en temps réel, puis lorsque le système sera validé, nous passerons à la prédiction» ajoute Priscille Janodet.

«Outre la création de données virtuelles, comme l’ammonium, nous utilisons l’IA pour faire de l’optimisation. Par exemple, nous indiquons des «règles du jeu» comme un minimum/maximum d’aération, une charge d’ammonium dans bassin, des contraintes de qualité des effluents, et l’IA va chercher à réaliser ces objectifs avec le coût énergétique le plus faible possible. On peut aussi optimiser la consommation de réactifs» explique Pauline Lorin pour Purecontrol. Xylem préfère décliner son offre Xylem Vue en trois mots clés : «voir, prédire, optimiser». «Voir» en temps réel le fonctionnement des installations, tout d’abord. C’est ce que proposent déjà les supervisions classiques, mais avec des données non «nettoyées» ni partageables. La prédiction, quant à elle, opère selon différentes modalités, comme l’explique Victor Philippon (Xylem).

«Il existe plusieurs types d’algorithmes de prédiction, basés sur de l’apprentissage supervisé à partir de données historiques. Par exemple, sur une STEU, on peut «nourrir» des réseaux neuronaux avec des données comme la qualité de l’eau entrante, les points de contrôle, les consignes (aération, etc.) et leur demander de prédire la qualité des effluent dans 30 minutes. On peut aussi prévoir l’écoulement dans un réseau de collecte en fonction de données météorologiques et pluviométriques, par exemple. Bien sûr, il existe déjà pour cela des modèles basés sur des équations déterministes de ruissellement, mais ils sont lents et difficiles à exploiter. Nous préférons utiliser de l’IA dans notre jumeau numérique du réseau, et obtenir toutes les 5 minutes une prévision de ce qui va se passer dans le réseau. L’IA peut aussi prévoir la consommation d’eau potable dans une ville: pour cela, il faut la «nourrir» avec au moins un an de données» énumère-t‑il.

L’optimisation, enfin, se fait en temps réel. «Par exemple, un opérateur humain ne peut pas assumer de manière optimale la gestion dynamique d’un réseau d’assainissement: il y a trop de possibilités à explorer simultanément. Nous mettons donc en place des optimiseurs numériques, basés sur des algorithmes génétiques ou des réseaux de neurones» illustre Victor Philippon. A cela s’ajoute une dernière nouveauté: les LLM (large language models ou grands modèles de langage), capables d’analyser le langage humain et de l’utiliser. On y vient donc… «D’ici la fin de l’année 2025, nous pourrons proposer un agent conversationnel (ou chatbot) qui permettra à l’opérateur de «converser» avec le logiciel» prévoit Victor Philippon.

DES BASSINS BIOLOGIQUES… À L’ENSEMBLE DU PETIT CYCLE DE L’EAU

Plusieurs fournisseurs se sont initialement faits connaître dans le domaine de l’assainissement pour leurs solutions d’optimisation énergétique de l’aération des bassins biologiques. L’IA gagne aujourd’hui le reste des installations: usines ou réseaux, en eau potable ou en assainissement. «En assainissement, nous optimisons toujours la consommation d’énergie de l’aération mais nous nous attaquons aussi à d’autres enjeux comme la limitation des émissions de N2 O ou l’adaptation de la capacité de traitement pour répondre aux nouvelles normes de rejet avec les installations existantes. C’est parfois l’enjeu financier qui domine : il s’agit alors d’obtenir le même rejet global sur 24 heures en jouant sur les variations du tarif de l’électricité. En moyenne, nous faisons gagner de 15% à 25% d’énergie à nos clients. Pour les réactifs, le gain est plus variable mais peut atteindre 50%» affirme Lynne Bouchy pour Createch.

Les exploitants de Lyon (STEU de La Feyssine, 300000 EH), Nantes, Lille ou Rouen font appel à la société pour optimiser leurs STEU. Createch intervient désormais également en eau potable, où l’optimisation porte surtout sur la consommation de réactifs ou d’eau de lavage des filtres. «En eau potable, il existe une forte synergie entre toutes les étapes de la filière, y compris les ressources amont. C’est pourquoi on nous demande désormais une vision plus intégrée. Par exemple, nous développons un projet pour une grosse usine de potabilisation utilisant des eaux de nappe, de surface et/ou de réutilisation. Leur filière de traitement est elle même très complète et l’on peut jouer sur toutes les étapes selon des objectifs économiques et/ou environnementaux. Au delà de l’optimisation des process, on nous demande là un véritable système expert» révèle Lynne Bouchy (Createch).

De la même manière, Purecontrol, connu historiquement pour la gestion de l’aération des bassins de STEU, diversifie son offre. Ses solutions peuvent par exemple optimiser l’injection de réactifs de dé-phosphatation (chlorure ferrique), les émissions de protoxyde d’azote (N2 O) ou l’utilisation des panneaux solaires en STEU, comme le pilotage des postes de relevage sur le réseau de collecte, que ce soit pour éviter les risques de débordement en épisode de pluie ou limiter la consommation énergétique par temps sec. «Puisque nous gérons plusieurs centaines de STEU, nous sommes également en mesure de réaliser des effacements électriques significatifs. Nous avons pour cela développé une API (Application Programming Interface) avec notre partenaire Agregio Solutions, une filiale d’EDF» précise Pauline Lorin.

«Nous avons récemment remporté l’appel d’offre de Rennes Métropole pour le pilotage par IA de l’ensemble de l’infrastructure d’assainissement, soit 17 STEU et 150 postes de relevage, la limitation des émissions de N2 O sur la plus grosse STEU (Beaurade) et l’optimisation des panneaux solaires sur plusieurs grosses STEU. Rennes est la première régie publique ayant publié un appel d’offre pour une utilisation aussi vaste de l’AI» affirme-t‑elle. L’intelligence artificielle permet également d’optimiser les performances énergétiques et environnementales des installations de traitement. En associant modèles physiques, IA et expertise humaine, des jumeaux numériques peuvent proposer en temps réel des ajustements sur les paramètres critiques (pH, température, contaminants…) afin de réduire les consommations d’énergie ou de produits chimiques, tout en garantissant la qualité de traitement.

Des économies d’énergie allant jusqu’à 20 % sont ainsi possibles, en particulier sur les étapes de pompage, d’aération ou de transport. Purecontrol va aussi assumer, pour le compte de Saint-Brieuc Armor Agglomération, le pilotage de la STEU du Légué, des postes de relevage et du pompage d’eau potable. La société propose en effet depuis 2024 l’optimisation des cycles de pompage et stockage de l’eau potable, ou fournit une aide à la détection de fuites. Purecontrol s’intéresse maintenant à la gestion prédictive de la ressource afin de piloter le pompage en fonction de la qualité de l’eau brute, ou à l’optimisation de l’utilisation du charbon actif pour retenir les métabolites de pesticides. Xylem propose de nombreux modules à destination de l’eau potable, que ce soit pour la production ou la distribution.

La ville de Trier (Trèves), en Allemagne, utilise ainsi une plateforme Xylem Vue pour produire une eau potable la plus décarbonée possible, dans le cadre d’une optimisation multisites car la ville dispose de plusieurs forages de qualité variable. Pour cela, le logiciel doit prendre en compte, entre autres paramètres, les capacités d’autoproduction d’électricité des usines munies de panneaux photovoltaïques (donc les données d’ensoleillement), celles d’une turbine installée dans un barrage, les niveaux dans les nappes (qui déterminent l’énergie de pompage) et la demande en eau potable, afin de fournir une aide à la décision sur la configuration de production.

Xylem lance également un gros projet avec la métropole Nice Côte d’Azur, dans le cadre de l’appel à projets Innov Eau de l’Ademe. Il comporte cinq applications «métier»: la priorisation des recherches de fuites (à partir de données réseau), l’élaboration d’un jumeau numérique du réseau (à partir de modèles hydrauliques, des données de supervision, des interventions, des données clientèle et du SIG) permettant de voir tout ce qu’il s’y passe et de simuler des interventions, l’optimisation du pompage/production (la métropole utilise de l’eau de surface et des forages, et fait tourner une turbine pour l’autoproduction d’électricité), une hypervision de la ressource2 (connectant des modèles hydrogéologiques et hydrologiques avec des données météorologiques ou satellitaires en temps réel), et enfin l’amélioration de la communication avec les usagers (sur la base de données du SIG et d’expertise sociologique, entre autres).

«Calasys s’adresse essentiellement au «petit cycle» de l’eau: de la potabilisation à l’assainissement. Cependant, nous avons commencé à travailler sur le traitement de données fluviales ou piézométriques, donc relevant du «grand cycle», afin de mieux comprendre l’état des ressources et développer une aide à la décision pour le pompage» affirme pour sa part Priscille Janodet (Calasys). D’autres acteurs appliquent l’intelligence artificielle au grand cycle de l’eau, en particulier aux ressources hydrologiques et souterraines. Aquasys, par exemple, a créé un pôle dédié à l’implémentation de l’IA en hydrogéologie, en s’appuyant sur une expertise scientifique issue d’une thèse CIFRE sur le calcul d’incertitude appliqué aux réseaux de neurones. Ces méthodes sont utilisées pour affiner les prévisions de hauteur et de débit des cours d’eau ou des nappes, avec des modèles intégrant la gestion de l’aléa.

En partenariat avec l’Université Gustave Eiffel, l’entreprise développe également des projets visant à généraliser ces modèles prédictifs et à améliorer l’efficience de l’irrigation, illustrant ainsi le potentiel de l’IA dans la gestion raisonnée des ressources à l’échelle du territoire. L’intelligence artificielle joue aussi un rôle croissant dans la prévention des risques liés aux crues et aux inondations. «Grâce à l’IA et aux données issues des rapports du GIEC, nous sommes en mesure de prévoir et d’analyser les impacts potentiels des crues sur les infrastructures, les équipements, et la continuité d’exploitation», précise Rodolphe Guillois, directeur général du Groupe Alcom et de sa filiale Examo. Cette anticipation concerne aussi bien les exigences réglementaires que les contraintes assurantielles, et vise à renforcer la résilience des territoires face au changement climatique.

SOLUTIONS SPÉCIALISÉES ET PLATEFORMES GÉNÉRALISTES

Les acteurs du domaine se répartissent entre spécialistes, souvent issus du monde du numérique, qui proposent des solutions très focalisées (tout au moins initialement, bien qu’elles tendent souvent à s’étendre à d’autres domaines par la suite) et des fournisseurs de «plateformes» intégrant dès l’origine de nombreux modules métiers… dont certains proviennent des spécialistes. Des sociétés comme Geomod by Coexya, Greencityzen (Hummbox), Birdz, Siemens (suite Siwa) ou Lacroix Sofrel interviennent sur ce marché, avec des approches souvent issues du numérique. D’autres, comme Aquassay, viennent au contraire du métier de l’eau: leur expertise originelle repose sur l’application de méthodologies d’efficacité hydrique, enrichies par le développement de solutions digitales spécifiques.

Les grands délégataires proposent également des offres numériques pouvant faire appel à l’IA et comportant, à la carte, des modules pour chaque aspect du cycle de l’eau, à l’instar d’Aquadvanced pour Suez ou d’Hubgrade pour Veolia. Certaines solutions, bien que non spécifiquement conçues pour le domaine de l’eau, peuvent s’y appliquer via des fonctionnalités génériques d’analyse de données ou d’optimisation industrielle. C’est le cas, par exemple, de l’outil MELSOFT MaiLab développé par Mitsubishi Electric. Il s’agit d’un environnement d’intelligence artificielle dédié à la science des données, initialement pensé pour les environnements industriels, mais qui peut être utilisé dans des cas d’usage liés à l’eau : optimisation de l’aération dans une station d’épuration, maintenance prédictive sur des équipements critiques, ou analyse de données issues de capteurs terrain.

«L’intérêt de ce type d’outil réside aussi dans sa capacité à capitaliser l’expertise humaine, et à faciliter le transfert de savoir-faire dans les équipes techniques, tout en rendant les systèmes plus autonomes», souligne Patrick Olivier, Division Manager Factory Automation chez Mitsubishi Electric Europe. La Diagbox de Calasys s’intègre dans l’écosystème numérique du client «Nous captons des données provenant de différentes sources et, réciproquement, d’autres outils peuvent utiliser nos données structurées pour d’autres applications», explique Priscille Janodet.

Createch opère pour sa part selon des configurations très variables, comme le précise Lynne Bouchy: «nous offrons des solutions incluant le traitement des données - sur la plateforme, chaque utilisateur personnalise ses indicateurs, alrtes et rapports automatiques en quelques clics – et le pilotage. Cette optimisation en temps réel est fondée sur des outils logiques élabrés sur mesure, en pilotant les équipements pour une performance de process optimum. Par ailleurs, notre solution peut fonctionner seule ou être intégrée dans une plateforme plus généraliste.»

Outre les habituelles «briques» de qualification des données et de modélisation pour prédire ou optimiser, la solution Purecontrol se distingue par sa capacité à communiquer avec les automates pour traduire l’optimisation calculée par l’algorithme en consignes effectives de fonctionnement - avec un pas de temps d’une minute, soit en temps réel pour ce type de procédés. «Notre solution fonctionne généralement de manière autonome, même si elle pourrait être intégrée à des plateformes généralistes. Les grands traiteurs font souvent appel à nous parce que notre solution basée sur l’apprentissage à partir de données de terrain est beaucoup plus «légère» et moins coûteuse que leurs systèmes utilisant la modélisation hydraulique» souligne Pauline Lorin.

Qualisteo travaille beaucoup sur la dimension énergétique, avec un positionnement original. «Notre solution se placera entre l’automate, qui donne les consignes, et l’équipement qui les exécute. Par exemple, si l’exploitant demande à un groupe de pompes de fournir un débit, notre système prend en compte cet ordre et cale les pompes sur leur meilleur point de fonctionnement énergétique. Nos algorithmes «intelligents» sont en effet capables de déterminer les points optimaux de fonctionnement des équipements ou process, en respectant les consignes mais en intégrant la dimension énergétique. De manière générale, les exploitants, surtout en eau potable, veulent garder la maîtrise et ne souhaitent pas laisser l’IA décider à leur place des paramètres du process. Nous espérons commercialiser cette solution fin 2025, sous forme d’un boîtier qui s’installera entre l’automate et l’équipement, et fonctionnera en boucle fermée» révèle Sébastien Papin.

La plateforme Xylem Vue comprend quant à elle plusieurs «étages». «Le socle est notre outil d’hypervision qui qualifie les données et les rend disponibles pour tous les services. A partir de là, l’opérateur est libre d’ajouter des modules «métier» de Xylem ou d’autres fournisseurs. Nous disposons de nombreux modules «sur étagère» mais en construisons aussi sur mesure à la demande, en particulier pour les problématiques d’optimisation que se font toujours au cas par cas» explique Victor Philippon.